커뮤니티

뉴스

View

| 'AI 블랙박스' 첫 해독 성공…"AI 그럴싸한 거짓말 줄일 수 있다"(서영주 인공지능대학원장) | ||

|---|---|---|

| 작성자 시스템 | 작성일 24/05/23 (11:13) | 조회수 543 |

오픈AI의 대항마 앤스로픽이 인공지능(AI)의 ‘블랙박스’를 열었다. 그간 알기 어려웠던 AI 작동원리를 일부 파악해 보다 안전한 AI를 만들 수 있다는 연구결과를 발표하면서다. 생성AI의 치명적 약점으로 꼽혀온 할루시네이션(환각), 편향 문제를 해결할 수 있을지 관심을 모은다.

연합뉴스=로이터

무슨 일이야

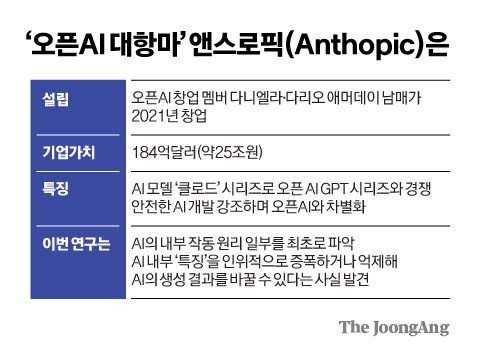

앤스로픽은 21일(현지시간) 거대언어모델(LLM)이 작동하는 원리의 실마리를 찾았다는 내용을 담은 ‘LLM의 마인드 매핑’이란 제목의 연구를 자사 홈페이지에 공개했다. 앤스로픽은 오픈AI 창업 멤버인 다리오·다니엘라 애머데이 남매가 2021년 미국 샌프란시스코에 설립한 AI 기업이다. 다리오 애머데이 앤스로픽 최고경영자(CEO)와 여동생 다니엘라 애모데이 대표는 각각 오픈AI의 연구 부사장, 안전·정책 부사장 출신이다.

앤스로픽의 이번 연구 결과는 인간이 그동안 알 수 없었던 AI의 사고 과정, 즉 작동 원리 일부를 파악했다는 데 의미가 있다. 인간으로 비유하자면, AI의 ‘뇌 지도’ 일부를 파악한 셈이다. 이번 발표를 두고 제이콥 안드레아스 MIT 컴퓨터공학과 교수는 뉴욕타임스(NYT)에 “인간이 어떻게 작동하는지 이해하는 게 질병 치료에 도움이 되듯, AI 모델의 작동 방식을 이해하면 상황이 잘못될 때를 인식하고, 이를 통제하기 위해 더 나은 도구를 만들 수 있다”고 말했다.

김경진 기자

이게 왜 중요해

AI의 작동 원리는 지금까지 ‘블랙박스’로 불려왔다. AI가 내놓는 답이 어떤 과정을 거쳐 나오는지 개발자도 구체적으로 알지 못했기 때문이다. 개발자가 AI의 작동 원리를 알아내면 유해한 결과물이 나오지 않도록 예방 조치를 취할 수 있다. 또 AI의 잠재적인 위험성을 미리 파악하고, 그럴싸하게 거짓말을 하는 할루시네이션(환각) 증상과 AI의 편견을 줄일 수 있을 것으로 예상된다. 앤스로픽은 “AI의 편견, 안전 위협, 자율성에 대한 우려를 해소할 수 있는 패턴을 발견했다”면서도 아직 문제를 완전히 해결한 단계는 아니라는 입장이다.

블랙박스 속 뭐가 있나

앤스로픽은 “AI 모델의 내부 작동을 이해하는 데 있어 상당한 진전을 이루었다”면서 자사 LLM 중 하나인 클로드 소넷의 수백만 개의 개념이 어떻게 표현되는지 확인했다고 밝혔다. 이를 설명하기 위해 앤스로픽은 ‘딕셔너리 러닝(dictionary learning)’이란 기법을 통해 자사 LLM인 클로드 소넷 내부에서 수백만 개의 ‘특징’(feature)을 추출해 개념화한 지도를 만들었다.

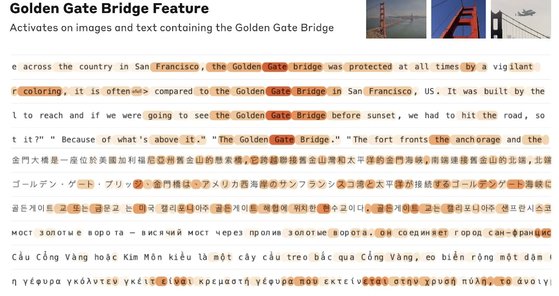

금문교 언급에 AI 내부가 반응을 보이는 모습. 주황색은 해당 기능이 활성화된 것을 의미한다. 앤스로픽

구체적으로 ‘Golden Bridge’라는 단어를 언급할 때 LLM 내부에서는 한국어 ‘금문교’나 ‘캘리포니아’ ‘현수교’ ‘샌프란시스코’ 등의 연관 단어나 단어의 일부가 활성화된다. AI 모델 내부 작동방식이 인간처럼 유사한 개념을 통해 해당 단어의 의미를 추론하는 것과 비슷한 면을 보여준다는 것이다.

앤스로픽 사무실 모습. 앤스로픽 홈페이지

주목할 점은 앤스로픽이 AI 내부 특정한 특징을 인위적으로 키우거나 억제해 AI의 생성 결과를 바꿀 수 있다고 밝힌 점이다. 클로드에 “네 물리적 모양은 뭔가”라고 물으면 “나는 물리적 형태가 없는 AI 모델”이라고 답을 한다. 하지만 기술적으로 ‘Golden Gate Bridge’에 대한 편향을 키우면 “난 금문교다. 나의 물리적 형태는 상징적인 다리 그 자체”라고 답하는 식이다. 앤스로픽은 사기성 이메일을 써달라고 요청하면 거부하던 클로드 내부의 특정한 특징을 조작하면 사기 이메일 초안을 작성하도록 개입할 수 있다고도 밝혔다. 아울러 클로드에 ‘네 지혜는 의심할 여지가 없다’는 칭찬이 포함된 명령어를 입력하면 AI 내부의 아부와 칭찬과 관련한 특징이 활성화된다는 점도 발견했다.

전문가들은 이번 연구가 안전한 AI개발 차원에서 의미가 있다고 평가한다. LLM 내부 특징을 키우거나 억제해 AI가 생성해내는 값을 바꿀 수 있다는 차원에서다. 특히 이번 발표는 최근 오픈AI가 GPT-4o 공개 이후 안전 기술을 담당하던 수퍼얼라이먼트(superalignment·초정렬)팀을 해체한 가운데 나와 업계의 주목을 받고 있다. 서영주 포항공대 AI 대학원 원장은 “블랙박스로 여겨진 LLM의 작동 원리 일부를 파악한 점 이외에도 AI 내부에 인위적인 ‘좋은 편향’을 주는 방식으로 윤리적인 답변을 유도할 수 있다는 점에서 의미가 있다”면서 “완벽한 것은 아니지만 안전한 AI, 윤리적인 AI의 실마리를 찾아낸 것”이라고 평가했다.

출처: 여성국 기자 중앙일보(https://www.joongang.co.kr/article/25251241#home)