연구

최신연구

View

| [옥정슬 교수] Towards Robust and Efficient Federated Low-Rank Adaptation with Heterogeneous Clients | ||

|---|---|---|

| 작성자 옥정슬 | 작성일 25/07/21 (00:00) | 조회수 160 |

[연구의 필요성]

연합학습(Federated Learning; FL)은 각 사용자 기기에 존재하는 풍부한 사적 데이터를 활용하면서도 개인정보 유출 위험을 최소화할 수 있는 학습 방식으로, 많은 양의 데이터를 필요로 하는 대규모 언어 모델(Large Language Model; LLM)의 학습에 매우 유용하다. 그러나 FL 환경에서 LLM을 미세조정(fine-tuning)하려면 수십억 개의 파라미터를 각 클라이언트가 로컬에서 학습하고 이를 서버로 전송해야 하므로 통신 및 연산 비용이 막대하다. 이를 해결하기 위한 자연스러운 접근 중 하나는 Low-Rank Adaptation(LoRA)을 FL에 도입하는 것이다. LoRA는 학습 및 통신해야 할 파라미터 수를 대폭 줄여주며, 그 자체로 효율적인 대안이지만, LoRA를 사용하는 기존의 FL 방법 중 다수는 데이터 분포가 서로 상이하거나 통신 리소스가 적은 현실적인 상황에서 성능 저하가 발생한다.

[포스텍이 가진 고유의 기술]

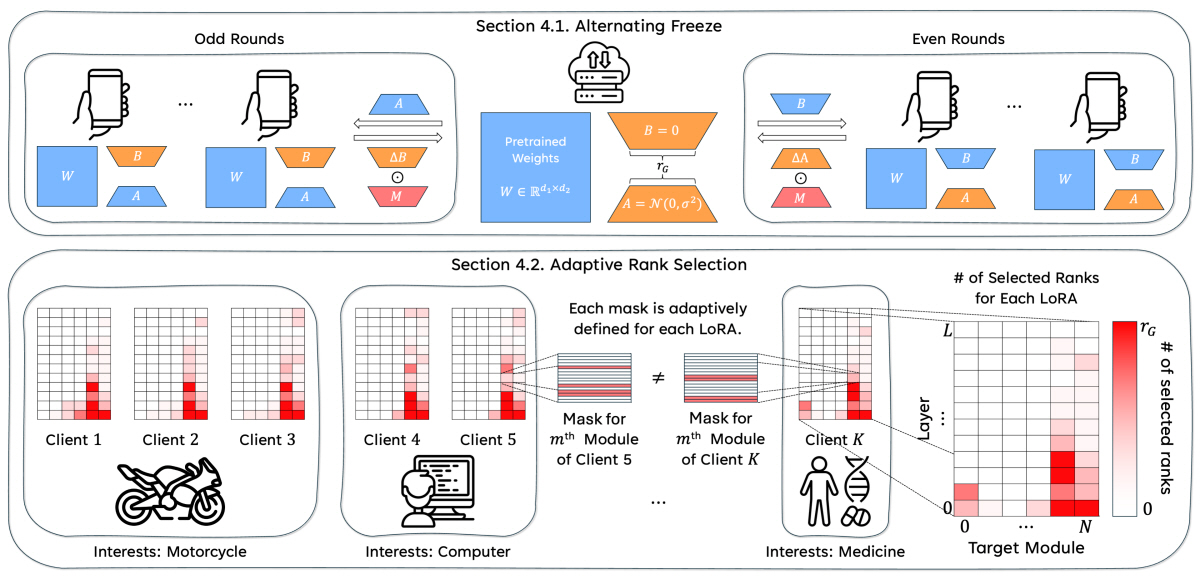

본 연구는 Alternating Freeze와 Adaptive Rank Selection이라는 두 가지 핵심 기술을 도입하여, 모델의 파라미터 탐색 공간을 효율적으로 활용함으로써 성능 저하 문제를 해결하였다.

- Alternating Freeze: 통신 라운드마다 LoRA의 두 행렬 B와 A를 번갈아 학습함으로써 기존의 불일치 문제(discordance problem)를 효과적으로 해결하였다.

- Adaptive Rank Selection:각 클라이언트는 로컬 데이터 기반으로 모듈별 rank의 중요도를 평가한 뒤, 가장 중요한 rank들만 선택적으로 학습하고 나머지는 마스킹(masking)함으로써 학습·통신 자원을 중요한 모듈에 집중시킬 수 있다. 이로 인해 서로 유사한 클라이언트 간에는 자연스럽게 협력이 유도되고, 데이터가 상이한 클라이언트는 독립적으로 학습하여 충돌을 방지하는 효과를 얻었다.

[연구의 의미]

Alternating Freeze와 Adaptive Rank Selection을 결합한 본 연구의 제안 기법 LoRA-A²는 통신·연산 예산을 대폭 줄이면서도 LoRA를 사용하지 않는 전체 파라미터의 미세조정과 동등한 수준의 성능을 유지하였으며,높은 데이터 이질성, 낮은 파라미터 예산 환경에서 기존 LoRA 기반 FL 방법론을 능가하는 성능을 보였다.

[연구결과의 진행 상태 및 향후 계획]

본 연구는 자연어 처리 분야 최우수 학술대회 중 하나인 The 63rd Annual Meeting of the Association for Computational Linguistics (ACL 2025)에 채택되어, 구두 발표 세션에서 발표될 예정이다. 향후에는 사용자 선호를 반영한 개인화, 멀티모달 학습으로의 확장, 그리고 FL 기반 파운데이션 모델 학습에 적합한 데이터셋 정제 전략 설계 등으로 연구를 확장해 나갈 계획이다.

[성과와 관련된 실적]

Jabin Koo*, Minwoo Jang*, and Jungseul Ok, "Towards Robust and Efficient Federated Low-Rank Adaptation with Heterogeneous Clients", ACL 2025 (main, long, oral<8% of accepted)

[성과와 관련된 이미지]